提示词热度飙升,ChatGPT 相关教程搜索量暴涨

现象 — Prompt / ChatGPT 教程 /提示词搜索量 & 使用量正在上涨

- 最近有报告指出,从 2025 年年初到 6 月,ChatGPT 的“prompt 交互量”(prompt usage / prompt volume)上涨了近 70%。

- 在全球范围内,“prompts for ChatGPT”(或“ChatGPT 提示词 / Prompt 教程 /Prompt engineering”)成为 AI 相关搜索中最热门关键词之一。

- 与此同时,有越来越多的研究与资源聚焦于所谓的“Prompt engineering”(提示工程):研究者将它视为让大型语言模型 (LLM) 输出高质量结果的关键技术。

换句话说,不仅普通用户在学习怎么写“好 prompt”,学术界 /开发者也在研究如何系统优化 prompt,这推动了整个“提示词文化 / prompt-engineering 社群 / 教学内容”的热潮。

为什么 prompt / 教程热度飙升 — 背后驱动因素

Prompt 是普通用户 /非专业人员也能“释放”AI最大能力的门槛

对于没有编程背景或机器学习基础的人来说,通过精心构造 prompt,就可以让 ChatGPT 执行写作、总结、翻译、创意、技术、规划等任务 — 使用门槛低、收益高。这让 prompt engineering 成为普遍需求。

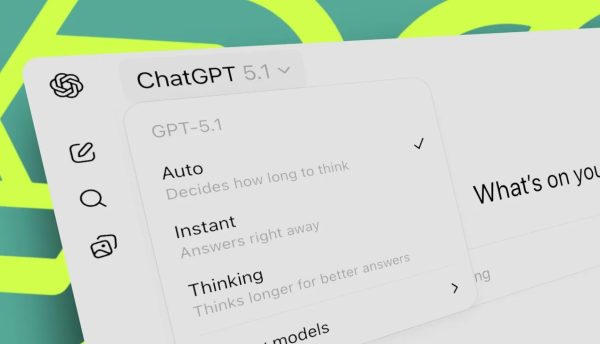

AI 模型(像 ChatGPT)能力提升 + 模态扩展,prompt 需求更复杂、更灵活

随着 AI 模型越来越强 — 不只是简单问答,还支持复杂任务、多轮对话、上下文管理、多模态 (文本 /图像 /结构化数据) 等 — 要让它发挥 “最佳效果”,简单 prompt 不足,需要更“结构化 /策略化 /工程化” 的 prompt 编写技巧,也就促进了 prompt 教程 /指南 /社区增长。

社会/工作/学习场景对 AI 输出质量要求提高

很多用户/组织把 ChatGPT 当成“辅助写作 /创作 /研究 /办公助手”。当用途从“聊天/娱乐”转向“专业/实用” — 比如写报告、合同、总结、方案、策略、代码、内容营销 — 输出质量与稳定性变得关键。为此,学习“怎么给 AI 一个好 prompt”成为必需。

信息/资源丰富 + 社群与分享带动增长

网络上有越来越多 prompt-教程博文、视频、论坛/社区 (包括开发者、内容创作者、普通用户) 在分享 “有效 prompt 案例 /模板/技巧”。这种分享加速了 prompt engineering 的普及,也吸引更多人搜索、学习。

Prompt Engineering — 不只是“写提示词”,而是一门技能 /方法

从学术与技术发展的角度,“prompt engineering”已经被认为是使用大型语言模型 (LLM) 的一门正规技术 /方法学。

比如,一些研究者正在探索“自动提示优化 / Auto-prompting / Prompt distillation” 方法 — 让系统自动为给定任务优化 prompt,以提升生成质量 /准确率。

这意味着,对于那些需要高效 /高质量 /复杂输出 (比如法律文书 /技术方案 /科研报告 /营销文案 /编程 /创意内容) 的用户,不再只是“多试几次 prompt 随机瞎写”,而是可以/需要系统化、方法化地“设计 prompt +任务 +上下文”,以获得稳定、专业、符合预期的输出。

这种趋势对不同类型用户的意义

| 用户类型 | Prompt 热度上升 / ChatGPT 教程增长 对他们意味着什么 |

|---|---|

| 普通用户 / 爱好者 /学生 | 更容易学习如何用 ChatGPT 帮助写作、创意、学习、规划 — 用 minimal effort 获取更好的结果 |

| 内容创作者 /博主 /营销人 | 有更好的方式生成文案、脚本、营销文案 / 布局 /标题 /构思 — 节省时间,提高产出 |

| 专业人士(律师 / 市场 /产品 /研究) | 可以通过 prompt + 上下文管理 + 多轮对话,让 ChatGPT 帮助起草报告、分析方案、总结资料、准备文档 — 降低重复劳动,提高效率 /精准度 |

| 开发者 / AI 从业者 /研究者 | prompt engineering 和自动优化 prompt(auto-prompting)成为一个研究方向 /实用技术 — 有利于构建可靠、可复用、性能更优的 AI 系统 /应用 |

风险与注意事项 — “prompt 热潮”也并非万能

- 虽然 prompt +技巧 +上下文能让输出更好,但 AI 本身并不总是可靠/完美 — 仍需人工审核 /判断,特别是用于专业/关键场合 (法律、医疗、财经等)。

- 过度依赖 prompt + AI 输出,可能降低人类自身对内容 /逻辑 /事实 /语义的把控 — 出错、偏差、误导等风险依然存在。

- Prompt 优化 / 提示工程也有复杂性 — 对很多用户来说,学习曲线 +时间成本并不总值得。